Теоретическое доказательство показывает, что метод, называемый гиперпараметризацией, повышает производительность квантового машинного обучения для приложений, которые ставят в тупик классические компьютеры.

«Мы считаем, что наши результаты будут полезны при использовании машинного обучения для изучения свойств квантовых данных, таких как классификация различных фаз вещества в исследованиях квантовых материалов, что очень сложно на классических компьютерах», — сказал Диего Гарсия-Мартин, научный сотрудник Лос-Аламосской национальной лаборатории. Он является соавтором новой статьи команды из Лос-Аламоса об этой методике, опубликованной в журнале Nature Computational Science.

Гарсия-Мартин работал над исследованиями в Летней школе квантовых вычислений лаборатории в 2021 году в качестве аспиранта Автономного университета Мадрида.

Машинное обучение, или искусственный интеллект, обычно включает в себя обучение нейронных сетей обработке информации — данных — и обучению тому, как решить заданную задачу. В двух словах, нейронную сеть можно представить как коробку с кнопками или параметрами, которая принимает данные в качестве входных данных и выдает выходные данные, зависящие от конфигурации кнопок.

«На этапе обучения алгоритм обновляет эти параметры по мере их изучения, пытаясь найти их оптимальную настройку», — сказал Гарсия-Мартин. «Как только будут определены оптимальные параметры, нейронная сеть должна быть в состоянии экстраполировать то, что она узнала из обучающих примеров, на новые и ранее невидимые точки данных».

Как классический, так и квантовый ИИ сталкиваются с общей проблемой при обучении параметров, поскольку алгоритм может достичь неоптимальной конфигурации в процессе обучения и остановиться.

Скачок в производительности

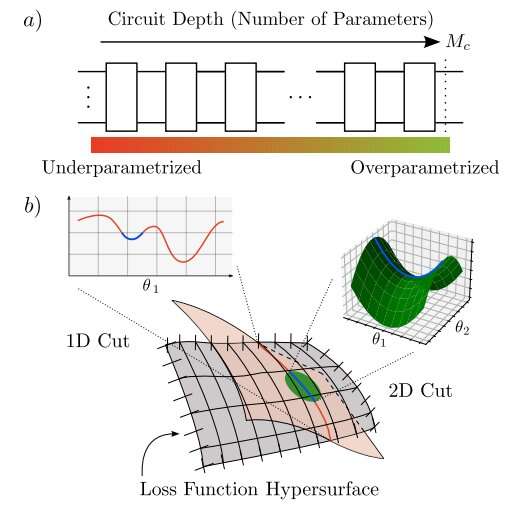

Перепараметризация, хорошо известная концепция классического машинного обучения, которая добавляет все больше и больше параметров, может предотвратить этот сбой.

Последствия чрезмерной параметризации в моделях квантового машинного обучения до сих пор были плохо поняты. В новой статье команда из Лос-Аламоса создает теоретическую основу для прогнозирования критического числа параметров, при которых модель квантового машинного обучения становится чрезмерно параметризованной. В определенный критический момент добавление параметров приводит к скачку производительности сети, и модель становится значительно проще в обучении.

«Устанавливая теорию, лежащую в основе гиперпараметризации в квантовых нейронных сетях, наше исследование прокладывает путь к оптимизации процесса обучения и достижению повышенной производительности в практических квантовых приложениях», — пояснил Мартин Ларокка, ведущий автор рукописи и постдокторский исследователь в Лос-Аламосе.

Используя преимущества таких аспектов квантовой механики, как запутанность и суперпозиция, квантовое машинное обучение обещает гораздо большую скорость, или квантовое преимущество, чем машинное обучение на классических компьютерах.

Как избежать ловушек в среде машинного обучения

Чтобы проиллюстрировать выводы команды из Лос-Аламоса, Марко Сересо, старший научный сотрудник статьи и специалист по квантовой теории в лаборатории, описал мысленный эксперимент, в котором турист, ищущий самую высокую гору в темном ландшафте, представляет процесс обучения. Путешественник может двигаться только в определенных направлениях и оценивает свой прогресс, измеряя высоту с помощью ограниченной системы GPS.

По словам Сересо, в этой аналогии количество параметров в модели соответствует направлениям, доступным для перемещения туриста. «Один параметр позволяет перемещаться вперед и назад, два параметра позволяют перемещаться в боковом направлении и так далее», — сказал он. Ландшафт данных, скорее всего, будет иметь более трех измерений, в отличие от мира нашего гипотетического туриста.

Имея слишком мало параметров, путешественник не сможет тщательно исследовать местность и может принять небольшой холм за самую высокую гору или застрять на равнинной местности, где любой шаг кажется бесполезным. Однако по мере увеличения числа параметров ходунки могут перемещаться в большем количестве направлений в более высоких измерениях. То, что изначально выглядело как местный холм, может оказаться возвышенной долиной между вершинами. С помощью дополнительных параметров путешественник избегает попадания в ловушку и находит истинную вершину или решение проблемы.